开源视频生成天花板?最强搅局者Mochi 1免费直出电影级特效

编辑:alan

何谓搅局?下面这些是模型直出的效果,开源免费送给你!

这也让一些网友直呼:「赛博菩萨」!

虽然很想把标题写成「剑指Sora」,但可惜这个标题小编我用过了~

而蓦然回首,那惊世骇俗的Sora也已经是很久之前的事情了。

今天,我们已经可以通过亲自与开源模型交互,来体验当初的震撼。

先来个高仿版世界名画:

是不是直接梦回当年?

开放权重:

源代码:

这个「赛博菩萨」名叫Mochi1,来自Genmo,模型的研究预览版已经在huggingface开源(或通过磁力链接下载),许可证,可免费用于个人和商业用途。

开玩!

神奇的魔法世界:

海上战争:

星际穿越:

月下美人:

开测这些都是来自discover页面的作品,有可能是网友做的,效果包不包真咱不知道,所以小编只好下场一试:

虽然但是还行吧,可能小编的提示词功力还需修炼。

下面这张的效果最令小编惊喜,尽管有些瑕疵,但基本能上官图了吧。

来看一下刻板印象(doge):

当然肯定也有翻车的时候:

翻车了吗?微翻,翻的不多,也就40%

另外模型的相关API也已经发布,开发者可以将其无缝集成到自己的应用程序中。

本地跑?huggingface上的模型权重大小为40多G,根据官方的说法,需要4个H100才能运行。

——不过别担心,既然敢开源,那么总有大神帮你解决问题:

地址:

Mochi1已经进入ComfyUI了,可以使用flashattention、pytorchattention(sdpa)或sageattention进行加速。

根据设置的帧数,可以把生成过程限制在20GB内存以下,作者还尝试了CogVideoX-diffusers来挑战更高的帧数,目前做到了97帧。

Mochi1模型架构

Genmo表示自己要搞一个「人工智能的右脑」,而Mochi1就是构建可以想象任何东西的世界模拟器的第一步。

Mochi1是基于新型的非对称扩散Transformer(AsymmetricDiffusionTransformer,AsymmDiT)架构构建的扩散模型。

Mochi1是完全从头开始训练的,同时提供了简单、可以自由修改的架构。

计算效率对于模型的发展至关重要。与Mochi一起开源的还有它的VAE编码器。

为了统一自我注意的模态,研究人员使用非方形QKV和输出投影层。这种非对称设计降低了推理内存要求。

许多现代扩散模型使用多个预训练语言模型来表示用户提示。相比之下,Mochi1只使用单个T5-XXL对提示进行编码。

为了定位每个token,研究人员将可学习的旋转位置嵌入(RoPE)扩展到3维,网络端到端学习空间轴和时间轴的混合频率。

其他的设计包括SwiGLU前馈层、用于增强稳定性的query-keynormalization,以及用于控制内部激活的sandwichnormalization。

详细的技术论文将在不久之后发布。

评估提示依从性

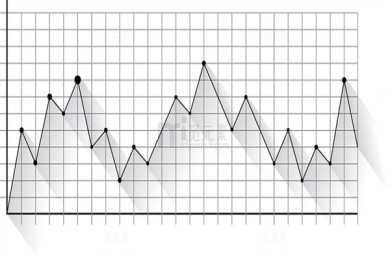

EloScore

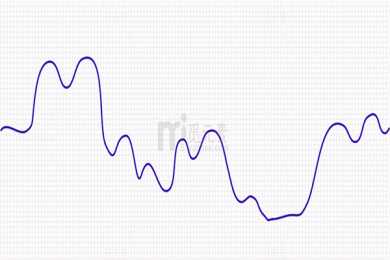

Mochi模拟流体动力学、毛皮和头发等物理特性,以及一致、流畅的人类动作,不存在恐怖谷问题。

评分者根据运动而不是帧级美学(标准包括运动的趣味性、物理合理性和流动性)来进行打分。Elo分数是按照LMSYSChatbotArena协议计算的。

局限性Mochi1目前仍处于不断发展的状态,存在一些已知的限制。

由于Mochi1针对照片级真实感样式进行了优化,因此在动画内容中表现不佳。

应用Mochi1的开源在各个领域开辟了新的可能性:

What'snext?Genmo近日宣布已经成功筹集了2840万美元的A轮融资,该轮融资由RickYang、NEA领投,TheHouseFund、GoldHouseVentures、WndrCo、EastlinkCapitalPartners和EssenceVC,以及天使投资人AbhayParasnis(Typespace首席执行官)、AmjadMasad(Replit首席执行官)、SabrinaHahn、BonitaStewart和MicheleCatasta等参投。

Genmo团队包括DDPM(去噪扩散概率模型)、DreamFusion和EmuVideo等项目的核心成员,由领先的技术专家提供咨询,包括IonStoica(Databricks和Anyscale的执行主席兼联合创始人)、PieterAbbeel(Covariant的联合创始人、OpenAI的早期团队成员)和JoeyGonzalez(语言模型系统的先驱、Turi的联合创始人)。

Genmo表示将在今年年底之前,发布Mochi1的完整版,其中包括Mochi1HD。